近日,数理医学院李刚团队及孙煜教授等人合作在脑机接口、人工智能领域顶级期刊IEEE Transactions on Affective Computing(影响因子9.8)上发表题为“STRFLNet: Spatio-Temporal Representation Fusion Learning Network for EEG-Based Emotion Recognition”的学术论文,有力推进了生物医学信号与人工智能交叉领域前沿性研究。浙江大学温州研究院副研究员胡佛为第一作者,数理医学院副教授李刚和客座教授孙煜为共同通讯作者。

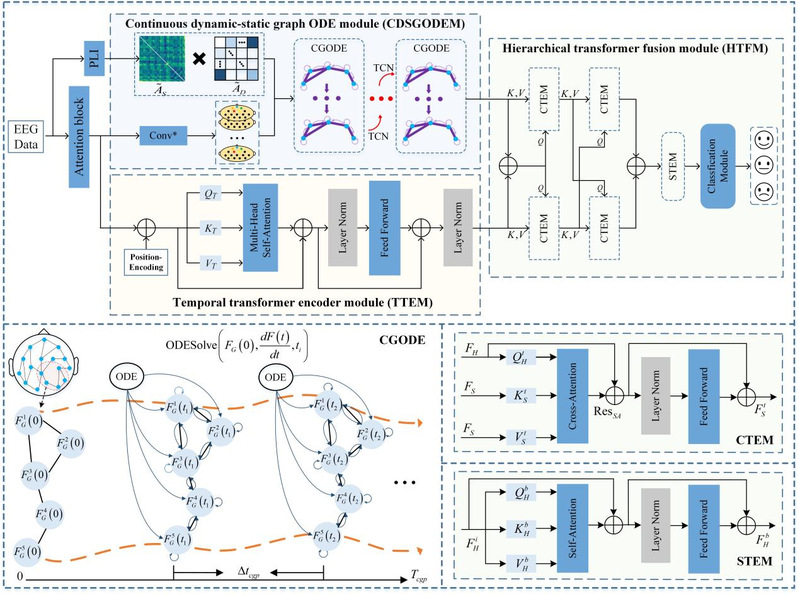

脑电(EEG)凭借毫秒级时间分辨率与非侵入式采集优势,被公认为情绪识别的理想信号来源。然而,EEG信号的非平稳噪声特性与时空深度建模不足问题仍制约着情感计算模型在真实场景中的稳健应用。为此,研究团队提出新型时空表示融合学习网络(STRFLNet),用于情感脑电的精确解码。该模型采用双分支框架:一条分支直接从多通道EEG中学习细粒度的时序依赖信息;另一条分支基于功能连接与动态拓扑构建动-静态融合图,并引入连续图常微分方程刻画深层空间特征传播模式,从而有效缓解深层图神经网络的特征同质化。随后,利用渐进式交叉融合模块对两路表征进行分层整合,以显著缩小特征分布差异,进而实现时空特征多语义层级的深度融合。实验结果表明,STRFLNet在多数据集上较主流方法取得显著提升,展现出更强的判别性与泛化能力,为情感计算的可靠落地提供了有力支撑。

图1. STRFLNet的整体架构.

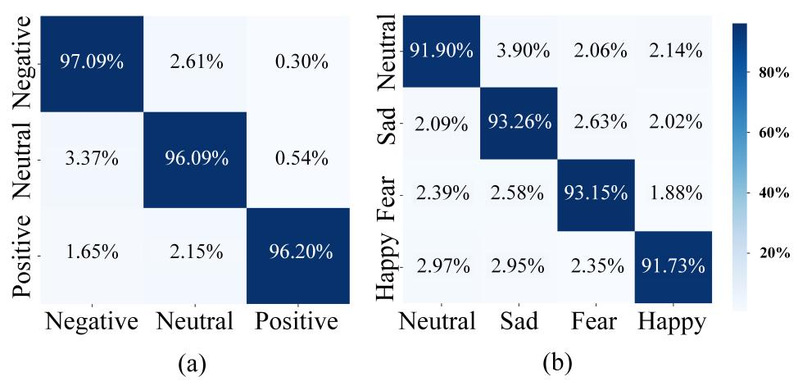

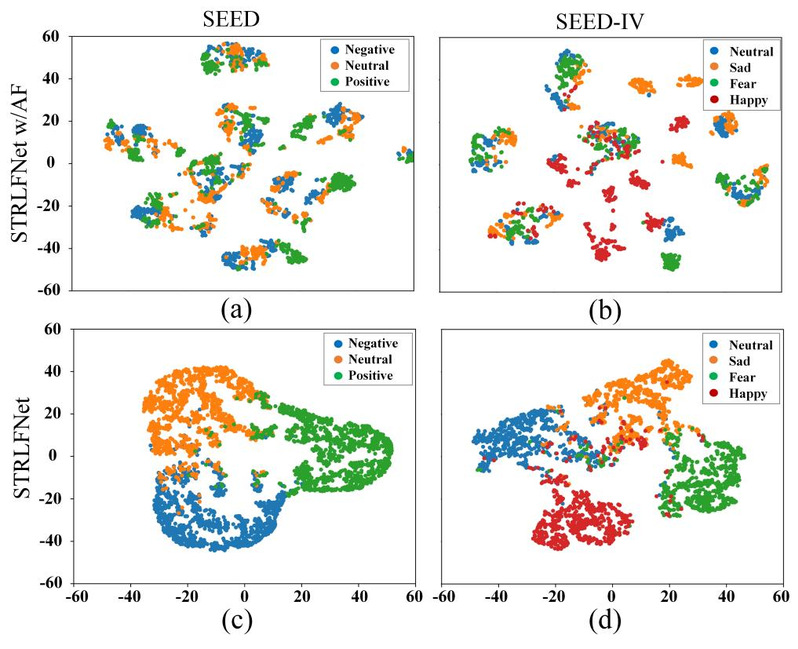

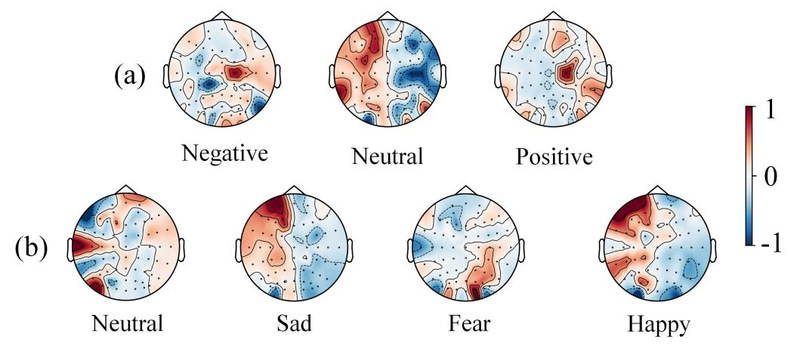

本研究在SEED、SEED-IV与DREAMER等公开数据集上对STRFLNet进行了系统评估:模型在SEED与SEED-IV上分别达到96.42%与92.23%的识别准确率,并在DREAMER上取得94.57%(效价)与96.03%(唤醒)的识别准确率,整体表现优于多种主流对比方法。在融合策略方面,所提出的渐进式交叉融合模块在多语义层级上实现时空特征的深度整合,显著优于简单级联、相加或单一注意机制融合方法。进一步地,相较于离散堆叠式图神经网络,结合图常微分方程(CGODE)的STRFLNet模型在保持/提升精度的同时,能提供更有效的空间特征深度传播机制并有效缓解过平滑问题。可解释性分析结果显示,模型所提取的高阶特征具备良好的类间分离度与类内聚拢性,不同情绪特征呈现可分化的时空激活模式。综合来看,STRFLNet在判别性、泛化性与可解释性方面均表现出稳健优势。

图2. 混淆矩阵:(a)SEED数据集;(b)SEED-IV数据集.

图3. t-SNE可视化.

图4. CAT可视化图.